テキスト1、ざっとですが読み終わりました。

第3部7章以降の推定と検定および統計モデルの話、ちょっとしんどいかもしれませんが、

- データを分析、解析する手法(何をしたいか)

- その手法のための統計量と分布

- 理論的な背景

- 具体的な手法(Pythonコード)

- 補足的な内容

をそれぞれ整理しながら読み進め、

- ひとまずコードを追って、手法を理解する

- 統計量と分布の種類を整理する

- なぜそうなるのかを理解する

などの目的に応じて、何を知りたいのか意識しながら読まれるのがよろしいかと思います。

推定¶

概要¶

推定はテキスト3-7に書かれていますが、できることは「点推定」および「信頼区間の推定」です。

点推定はずばり、標本から平均、分散を求めて、母平均、母分散を推して定める、というわかりやすいものです2。(あっけない感じがしませんか?w)

対して、「信頼区間」は値という「点」ではなく、区間という「幅」で推定するもの。

幅で推定すると何となく、その区間の中に母平均が入るんだろうな、と直感的にわかるかと思います3。

たとえば、高校生の平均身長を調べたいとき、全国の高校生の身長測定の結果があれば、母集団にほぼ近い標本を得られているので、母平均を高い精度で点推定できます。

ただ、手に入る標本が自分のクラス30名分だけのとき、そのクラスの平均をもって母平均を推定してよいのでしょうか。

点推定は標本が多いとき、信頼区間は標本が少ないときに有効な推定手法と考えられるでしょう。

手法や分布¶

このテキストでは母集団が正規分布に従っていると仮定したときの平均値や分散を推定する方法(というよりもそのものの統計量)を紹介しています。

また、標本平均を標準化した$t$値の分布が$t$分布に従うことを利用して、区間推定できることを説明しています。

検定¶

概要¶

検定は様々な手法がありますが、簡単にまとめると、仮説が正しいかどうかを調べるものです。

今まで統計学を学ぶ動機は,この検定を身につけるため,という人が多かったほど,非常に大事な統計手法でした.

ただ,人それぞれに思うところはあるでしょうが,現状の認識として,テキストp.231にあるように

いつかは不要になるかもしれない.けれども,それは今日ではない

と考えている人が少なくないでしょう.

でも,とはいえ,統計学を研究に利用している人の大半は,今でもこれを使っています.そのため,統計学の教科書にはこの内容が必ず出てきますし,検定は当然知っているという前提で話が展開されることもあるので,ざっくりとでも知っておいたほうがよいでしょう.

ケースとして,例えば,高校生3年生男子の平均身長は170cmと調査によって分かっています.

でも,私がいる3年B組の男子の平均身長は165cmです.

どの生徒がどのクラスに入るかは依怙贔屓とか何か理由があって選ばれているわけではないので,たまたま背が低い人がクラスに集まってしまっただけでしょう.

いや,でも,本当にこのクラスは明らかに背の低い人が意図的に集められたのではないだろうか.(背の低さを基準に選ばれていないとしても,例えば運動が苦手な人,体育会系でない人,がり勉タイプなど,背が低い人が多い属性の人を意図的に選んでいるのだろうか…)

という疑問を抱いたときに,統計的にどう扱うか.

「このクラスの平均身長から推定される母集団の平均身長は170cmである」という仮説を立てて,この矛盾(統計的な誤り)を導けば,「このクラスは,平均身長170cmの母集団からランダムに選ばれたクラスではない」ということを主張できるようになります.

この一連の流れが統計的仮説検定の1つのケースになります.

つまり,結論を得るために反駁したい仮説(帰無仮説:棄却したい!)と導きたい結論となりうる仮説(対立仮説:帰無仮説の逆)を立てて,統計的に検証するという方法です.

大事なことは,「Aである」という仮説の正しさを導くために,「Aでない」という仮説は間違っていると思われる,という二段階で否定することを行うのです.

この構造を意識しないと,よくわからん分布とかがでてくるので,すぐにわけわからなくなります.

手法や分布¶

推定と同様に、母集団は正規分布に従うことを仮定しています。

ある分布の平均値について調べるときに$t$分布を用いる$t$検定を行うことを3-8で説明しています。

2つの分布について、それぞれの平均値が有意に異なっているか、をしらべるときにも同様に$t$分布を利用しますが、上の手法の時とは統計量が異なることを3-9で説明しています。

青/赤のボタンについて、クリックした/しないをまとめたそれぞれの度数について、有意に異なるかどうか、を調べるために、$\chi^2$分布を利用する$\chi^2$検定を3-10で説明しています。

複数の分布について、平均値の差は意味のある違いか、データの誤差による「あまり意味のない」違いかどうか、を調べるために、$F$分布を利用する分散分析を5-2および5-3で説明しています。

補足¶

検定で判断の基準とされる$p$値については、特に近年、問題点として話題に上がることが多いです4。

そのため、テキストでも3-11で1章分を割いて、正しく検定結果を解釈できるように説明されています。統計学の教科書では、割と珍しいですが、最近のニーズに応えた内容になっているように感じます。

ただ、アカデミックな領域であればしっかりと押さえておかなくてはならない内容ですが、趣味で勉強する範疇でしたら、ひとまず流し読み程度でもよいように感じます。(機械学習界隈では、そもそも機械学習的な手法がブラックボックス化されているという問題のほうが大きく、再現性については、あまりとやかく言われない印象です)

統計モデル¶

概要¶

統計モデルは簡単に言えば回帰による分析です。

テキストにある例であれば、あるお店のビールの売り上げを、その日の天気や気温、湿度によって予測するための手法です。

予測したい変数(ビールの売り上げ)を応答変数、予測に用いる変数(天気や気温など)を説明変数と呼び、説明変数が1つの場合は「単回帰」や単に「回帰」と、説明変数が複数あるばあいは「重回帰」などと呼ばれます。

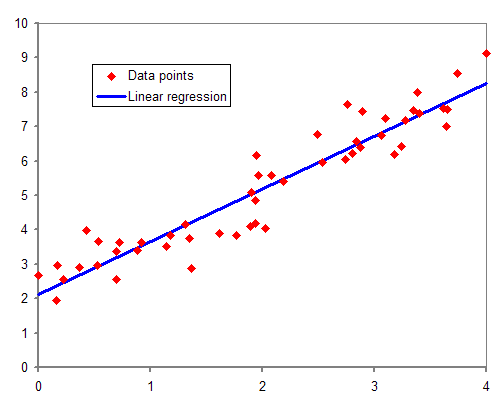

個人的には、いわゆる「統計学」のイメージが強い、散布図を直線によって説明するアレです。

By 英語版ウィキペディアのAmatulicさん (same as Anachronist on Wikimedia) - en.wikipedia からコモンズに移動されました。 Transfer was stated to be made by User:anachronist., パブリック・ドメイン, Link

概要の説明を第4章で、単回帰については5-1で、重回帰に関する内容は第6章で説明されています。

手法や分布¶

回帰分析では、変数がどのような分布に従っているか、や、どのように予測するか(テキストでは基本的に最小二乗法)によって、手法が異なります。

たとえば、変数が二項分布に従う2値(受験の合否など)の場合はロジスティック回帰(6-3で説明)、ポアソン分布に従う場合はポアソン回帰(6-5で説明)などです。(正規分布に従う場合は、特に名称が決まっていないみたいです。たぶん、正規分布を仮定するのが一般的なので、特別なケースにのみ名称がある感じ)

補足¶

統計モデルは、変数がどのような分布であるか、説明変数として何が適切か、など適切なモデルを組み立てることが非常に重要です。

古典的な統計学では、標本をとる前に必ず実験の目的とそれに応じた計画を立て、必要に応じたデータを入手することが大きな課題でしたが、ここでは、どちらかというとデータをもとに何が説明できるか、というところに重点が置かれているように感じます5。

情報量規準AICによる変数選択の説明が多いのは、このテキストの特徴じゃないでしょうか。(一般的な統計学の教科書では紹介程度に載っているような気がします)

第7章で紹介されているLasso回帰なども変数選択の手法ですが、機械学習周辺の話題として取り上げられることが多いです。

ニューラルネットワークなどの説明とともに、このテキストの特徴的なところであると思います。

最後に¶

この1冊で、いろんな分析ができるようになる!というわけではないですが、さまざまな話題が平易に書かれてますので、ざっと全体を概観できるようになってから、さらに深く突っ込みたいところに突っ込んでゆく、というのがよいかと思います。

統計学は手法や話題が本当に多いので、現在地点を見失ってしまったときに、ニュートラルな視点に戻れる1冊があると、心強いと思います。

では、引き続き、楽しんでいきましょう~

馬場真哉(2018).Pythonで学ぶあたらしい統計学の教科書、翔泳社。↩

3-5-15~17に説明がありますが、推定量を定めるのも、理論的な背景があります。不偏性、十分性、一致性などで推定量の良しあしを測ります。たとえば、1-7-6および1-7-7で分散と不偏分散が定義されましたが係数が$\frac{1}{N}$か$\frac{1}{N-1}$で、どう違うの?というところの意味はこの「不偏性」を持っているかどうか、というところにあります。↩

ただ、テキスト3-7-12でシミュレーションしているところはちょっとよくわからないような感じがしませんか?岩沢宏和(2014).世界を変えた確率と統計のからくり134話p.226から引用すると

ネイマン=ピアソン(信頼区間の生みの親)の流儀によればこの「信頼区間」を生み出した人は、「特定の区間推定を行っている際に、(たとえば)その道母数が95%信頼区間に収まる確率は95%であるというように考えてはならない。しかし、確率でないとしたら、信頼係数は何なのか。それを(ネイマン=ピアソン流の)教科書的に説明すれば、何度も何度も(たとえば)95%信頼区間を作っていくということを積み重ねていけば、信頼区間のなかに母数の真の値が収まる割合は95%に近づいていく、というものである。

と説明しているので、シミュレーションの通りなのですが、実際の現象について考えてみると、何度も信頼区間をとって、そこに母数が入る確率が何を表しているのか、よく分からないように感じます。信頼区間は直感的にわかりやすく感じるのと、計算しやすいため、用いられることが多いですが、発明された当初から批判されることも少なくないようです。

↩たとえば心理学分野における再現性の危機などは、さまざまな要因の一つとして、正しく$p$値を用いられていないことが話題になっています。(「再現性の危機」Wikipediaを参照)↩

あくまでも個人的な印象です。実際には、目的に応じて集められていないデータをもとに「なんか分析してくれ」と放り投げられて頭を抱えるデータサイエンティストは非常に多いです。また、フィッシャーという偉大な統計家は実験を行う前の計画の重要性を示すのに

実験終了後に統計学者に相談をもちかけても、それは統計学者に検死を行ってくれといっているにすぎないことがよくある。

という有名なセリフがある。

↩

0 件のコメント:

コメントを投稿